AI工作流的30分钟边界

AI工作流的30分钟边界

今天折腾了一整天AI工作流,BMAD、ralph-loop、planning-files、helloAgent轮番上阵,结果呢?还是卡住了。

正当我怀疑人生的时候,刷到了Metr.org的一篇文章,看完直接给我整醒了。

(https://metr.org/blog/2025-03-19-measuring-ai-ability-to-complete-long-tasks/)

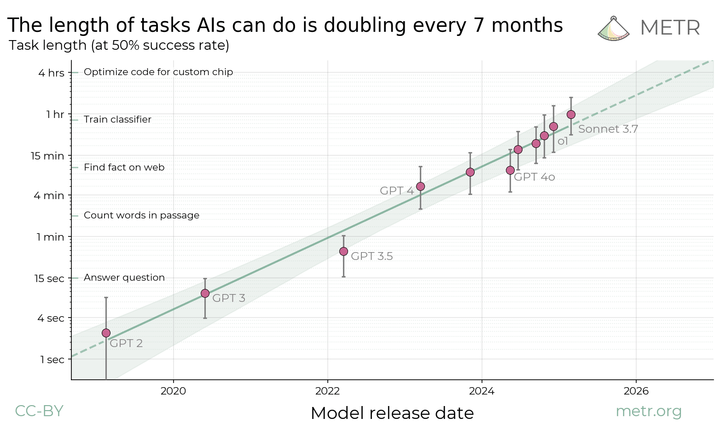

文章主要讲了AI的快速发展,每七个月处理能力就会翻一倍。但是我更关心的是AI现在的能力有多强?

文章里有个数据让我挺意外:目前最牛的模型,像GPT-5.2、Opus 4.5这些,50%成功率的任务能顶到2.5小时。但这个数据有个问题——它说的是成功率一半。

真正要看的是80%成功率,那个数字只有30分钟。

说实话,这个数据挺让人清醒的。

你说现在的模型强不强?肯定强。但30分钟是什么概念?就是一个人工坐那儿半小时能干完的活儿,AI才能有八成把握搞定。如果是智谱这些国内模型,成功率可能还要打折扣。

这让我突然想通了一件事:搞工作流之前,得先掂量一下这活儿有多重。

如果这活儿超过半小时,想靠脚本自动化完成?悬。

你可以用文件系统做中间介质,可以搞无限上下文,但任务复杂度一旦超过人类半小时的工作量,失败率就蹭蹭往上涨。

尤其是多Agent系统,更是翻车重灾区。

如何提高Agent处理复杂问题的能力?

这件事其实目前大家都在努力的做尝试,希望AI可以做更多更难得任务。

一个办法是提高大模型的性能。按照现在每7个月时长翻倍的速度,2027年AI的80%成功率能撑到2小时,2028年到8小时——基本等于一个人工的工作日了。到2029年能到32小时,差不多一周的工作量。那时候就稳了。

另一个办法是任务拆解,把大活儿拆成半小时以内的小块。听着挺合理,对吧?

但问题来了,我们做一个简单的数学题:如果你把一个1个半小时的任务拆成三个串联的子任务,每个成功率80%,那么整体成功率就是0.8 × 0.8 × 0.8 = 0.512。本来 50% 的成功率时间就是两个半小时,还不如不拆!

所以现在最靠谱的策略?用最强的模型啃最硬的骨头。

你要是真想拆,也行,但别想着全自动化。拆任务有两个前提:第一,任务是可并行的;第二,每步都能验收。不然拆了也是白拆。

说到底,2小时以上的活儿,目前还是人工靠得住点。不过这局面变化很快,指不定哪天就被颠覆了。

说到这儿,我想起之前写过AI编码工作流的文章。当时花了很大精力搭了一套自动化流程,5步闭环、两层判断,看着特完美。

但看到这个数据,我突然意识到一个之前没想通的问题:AI自动化不是万能药,它有边界。

边界在哪?30分钟。

超了这个时间,Agent就不如人工靠谱了。

不过这不代表AI没用。恰恰相反,它的价值在于帮你处理那些重复的、机械的、半小时以内的小活儿。真正复杂的任务,还得靠人拿主意。

有些事AI做得好,有些事必须人来。

关键是什么?你得知道什么时候该让AI上,什么时候得自己来。

这就是我今天写这些的原因——不是因为AI不行,而是我更清楚它的边界在哪儿了。